Всем привет!

В данной статье описан один из возможных сценариев как можно развернуть сервис в On-Site, с которым поделился наш партнер "Baso-IT" в лице Александра Горчакова. Данная инструкция процитирована и зафиксирована в таком виде, в каком партнер нам передал.

Характеристики (из расчета ~70 почтовых ящиков):

- одна виртуальная машина (Ubuntu без предустановленных настроек с root-доступ)

- 2 ядра по 2 Гц

- с оперативной памятью 4gb

Шаги, которые были предприняты для разворачивания сервиса (текущую машину будем считать master-машиной):

(!) за основу брать инструкцию по разворачиванию сервиса на Академии - https://academy.terrasoft.ru/documents?product=administration&ver=7&id=2075

1. На "чистой" Ubuntu (версия 20.04) создаем нового пользователя

adduser username

и добавляем его в группу sudo:

usermod -a -G sudo username

ssh-доступ он получит по умолчанию.

(!) Далее если система где-то будет ругаться на root-доступ или отсутствие прав - просто добавляем в начале команды sudo

2. Логинимся под созданным пользователем и устанавливаем Midnight Commander, для более удобного пользования каталогами:

apt install mc

При установке система может задать вопрос - выбираем Y

3. Обновляемся и ставим Docker:

apt-get update

apt-get install -y docker.io

Стоит его так же сразу перезапустить:

service docker restart

4. Устанавливаем kubeadm, kubelet и kubectl:

apt-get update && apt-get install -y apt-transport-https

curl -s https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add -

cat <<EOF >/etc/apt/sources.list.d/kubernetes.list

deb http://apt.kubernetes.io/ kubernetes-xenial main

EOF

ИЛИ (нужно знать как работать в редакторе VIM (https://help.ubuntu.ru/wiki/vim)

apt-get update && apt-get install -y apt-transport-http

curl -s https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add -

sudo vim /etc/apt/sources.list.d/kubernetes.list

deb http://apt.kubernetes.io/ kubernetes-xenial main

Здесь может оказаться так, что система не даст создать файл kubernetes.list ввиду отсутствующего каталога sources.list.d

Если так случится - сначала используем mkdir и создаем каталог:

mkdir /etc/apt/sources.list.d

Далее повторяем последние 3 команды из пункта 4:

cat <<EOF >/etc/apt/sources.list.d/kubernetes.list

deb http://apt.kubernetes.io/ kubernetes-xenial main

EOF

Устанавливаем Kubernetes:

apt-get update

apt-get install -y kubelet kubeadm kubectl kubernetes-cni

5. Далее выполняем команду:

kubeadm init --pod-network-cidr=10.244.0.0/16

Именно 10.244.0.0/16! Вводим ровно то что написано.

Процесс может занять минуту или более в зависимости от вашего интернет-соединения.

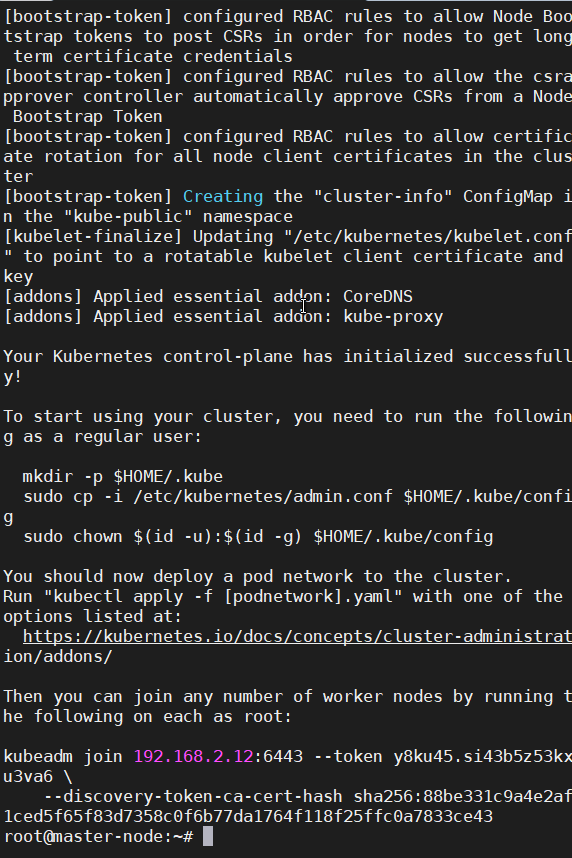

Результат выполнения команды

В процессе установки могут быть Warning и Error. Последние сначала придется устранить.

Самый популярный Error - жалоба на swap. Замечу что банальной команды отключения swap (swapoff -a) недостаточно, т.к. даже в случае успешной установки - после перезагрузки системы придется повторно ее вводить каждый раз, что не очень удобно (иначе просто ничего не будет работать).

Рекомендую запустить тот же MobyXTerm или Midnight Commander (mc), найти файл fstab ("/etc/fstab"), расположенный в каталоге etc и просто закомментировать (поставить в начале строки #) строку, в которой содержится слово swap и перезагрузить машину.

Так же можно просто не создавать swap-раздел при установке ubuntu.

В случае успешного выполнения система предоставит команду для подключения других машин к текущей для создания кластера (выдуманный пример):

kubeadm join 192.168.101.199:6443 --token selist.zho8rggai807dtsr \

--discovery-token-ca-cert-hash sha256:8250d1a19e1c9bc7ab32ef43811f143f1c658ccc476383e9260d133a2988666c

Сохраните полученную команду и используйте при необходимости собрать кластер.

Так же в процессе выполнения могут быть Warning'и вида:

docker service is not enabled, please run 'systemctl enable docker.service'

Собственно вводим то что написано:

#Как вылечить сообщение [WARNING Service-Docker]: docker service is not enabled, please run 'systemctl enable docker.service'

systemctl enable docker.service

Или же такие:

detected "cgroupfs" as the Docker cgroup driver. The recommended driver is "systemd"

В таком случае создаем\редактируем файл daemon.json, расположенный по пути etc/docker (можно вручную отредактировать через cat или vim):

{

"exec-opts": ["native.cgroupdriver=systemd"]

}

Но можно и командой, которая все делает:

#Как вылечить [WARNING IsDockerSystemdCheck]: detected "cgroupfs" as the Docker cgroup driver. The recommended driver is "systemd". Please follow the guide at https://kubernetes.io/docs/setup/cri/

cat > /etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2"

}

EOF

И перезапускаем Docker:

service docker restart

Но в целом это скорее просто рекомендация. Работать будет и так.

6. Вводим команды:

sudo mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

7. Вводим команду для возможности запуска контейнеров на текущей машине:

kubectl taint nodes --all node-role.kubernetes.io/master-

8. Устанавливаем Flannel:

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/k8s-manifests/kube-flannel-rbac.yml

9. Проверяем состояние подов:

kubectl -n kube-system get pods

Должны быть статусы Running

10. Устанавливаем Helm:

wget https://get.helm.sh/helm-v3.3.0-rc.1-linux-amd64.tar.gz

tar xzvf helm-v3.3.0-rc.1-linux-amd64.tar.gz

mv linux-amd64/helm /usr/local/bin/helm

Название дистрибутива может меняться. В данный момент это текущая актуальная версия.

И подключаем репозиторий (возьмем самый популярный):

helm repo add stable https://kubernetes-charts.storage.googleapis.com/

11. Устанавливаем Redis:

helm repo update

helm install --namespace default --set usePassword=false --set=slave.persistence.enabled=false --set master.persistence.enabled=false --set cluster.enabled=false redis bitnami/redis

Я использовал namespace k8s по умолчанию (default). Как и название Redis'а (redis).

12. Устанавливаем Exchange Listener.

Качаем последний актуальный дистрибутив (на данный момент 0.6.9):

wget http://ftp.bpmonline.com/support/downloads/Exchangelistener/exchangelistener-0.6.9.tgz

Находим ip-адрес redis-master:

kubectl get service

В выводе в столбце ClusterIP будут ip-адреса. Нас интересует redis-master

Допустим это 10.104.17.189

В таком случае следующая команда будет выглядеть:

helm install --set env.host=10.104.17.189 --set service.type=NodePort --set service.nodePort=30001 --set apiVersion=apps/v1 --namespace default elistener exchangelistener-0.6.9.tgz

Где:

--set env.host - указать IP мастер Redis

default - namespace, который использовался в пункте 11.

elistener - произвольное название нашего сервиса.

exchangelistener-0.6.9.tgz - путь к скачанному дистрибутиву.

Порт не обязательно должен быть 30001. Допустимый диапазон 30000-32767.

На этом минимальная настройка сервиса на стороне сервера завершена.

Пункты 1 и 2 тоже не могу назвать обязательными. Это скорее рекомендация для личного удобства.

Проверяем состояние сервисов:

kubectl get pods

Должны быть состоянии Running.

Проверяем доступность сервиса Exchange Listener.

Сначала можно через telnet:

telnet 192.168.101.199 30001

Где 192.168.101.199 - ip-адрес нашей linux-машины, а 30001 - порт сервиса Exchange Listener, выбранный при установке на 12 шаге.

Если соединение проходит - открываем веб-браузер (желательно сразу на машине с Creatio) и вводим в адресную строку http://192.168.101.199:30001/api/listeners/status

Вывод должен быть вида "ServiceStatus": "Started", и т.д.

Дополнительно:

При желании собрать кластер, на всех дополнительных машинах проделываем:

Вводим команды, описанные в Error'ах и Warning'ах шага 5 (саму команду kubeadm init --pod-network-cidr=10.244.0.0/16 не вводим)

Вводим ключ-команду полученную на на шаге 5. Замечу что нужно стереть символ \ если он присутствует.

Проверяем поды на master-машине (их должно стать больше):

kubectl -n kube-system get pods

Какие команды могут помочь при решении проблем

Почему-то не было доступа из внешнего IP к порту 30001, где развернут сервис. и были выполнены следующие команды:

ufw allow 30001 - команда конкретно firewall ubuntu. К другим дистрибутивам вероятнее всего не подойдет (возможно только если к Mint, т.к. ядро тоже самое).

iptables -I INPUT -p tcp --dport 30001 -j ACCEPT - уже более распространенный вариант.

Команды для просмотра логов. Примеры:

kubectl logs POD_NAME

kubectl logs REDIS_NAME-api-0

Спасибо!